Ce qui consomme le plus d’énergie, dans un serveur informatique, c’est son refroidissement. Une problématique dont s’est saisie Datacampus, une entreprise située à la Technopole du Futuroscope de Poitiers. Cet hébergeur de données et de logiciels libres fonctionne avec des data centers classiques, mais est également pionnier dans l’utilisation d’une technologie innovante : celle de l’immersion des serveurs dans une solution d’huile minérale, qui minimise leur impact énergétique. Interview de Pierre Pluviaud, directeur général et fondateur.

Quels sont les impacts environnementaux des data centers classiques ?

Les data centers, c’est la partie non visible d’internet ; une partie qui représente à la fois une perte d’énergie et d’espace considérable. D’abord, les serveurs consomment et chauffent énormément, ce qui nécessite d’avoir constamment recours à la climatisation. Dans un data center, 30 à 40% de la consommation globale d’électricité est consacrée au refroidissement et à la dissipation de la chaleur émise. De plus, les serveurs sont généralement organisés dans des armoires qui occupent un espace considérable au sol. Se pose aussi la question de la réadaptation des bâtiments : dans un data center, les murs sont extrêmement épais, il n’y a pas de fenêtre, le sol est décaissé pour pouvoir faire passer du câble… Il serait donc extrêmement difficile de l’adapter à un autre usage, de le convertir en bureaux ou en espace de stockage, par exemple. Or, le cycle de vie des data centers constitue une vraie problématique. Au bout d’une vingtaine d’années, ils commencent généralement à devenir obsolètes. Les systèmes anti-incendie, climatisation et autres infrastructures volumineuses, c’est même tous les dix ans qu’il faut les changer. Tout cela représente à la fois un coût financier et un coût pour l’environnement. Et puisqu’un data center ne peut servir qu’à une chose ou presque, une fois en fin de vie il y a le risque, comme n’importe quelle usine, qu’elle termine en friche industrielle.

En quoi la technologie utilisée par Datacampus offre une solution à ces problématiques ?

Pour réduire l’impact environnemental de l’hébergement de données, nous utilisons exactement les mêmes serveurs que dans un data center classique, à la différence que nous les immergeons complètement dans un liquide de refroidissement, évidemment non conducteur. Celui-ci absorbe la chaleur à la source et permet de se passer d’une climatisation particulièrement gourmande en électricité. Et comme l’immersion permet de mieux dissiper la chaleur, on peut également entreposer des serveurs beaucoup plus puissants. Pour donner un ordre de grandeur, dans un bain d’un mètre carré environ, on entrepose 60 kW de puissance informatique, alors que dans une salle de data center traditionnelle, quand on met 15 kW dans un mètre carré, c’est déjà énorme. L’immersion permet donc de quadrupler les performances. Concrètement, pour refroidir ces 60 kW de puissance informatique, on n’a besoin que de 2 kW, au lieu de 20 dans un data center conventionnel. C’est la nature de l’économie d’énergie qui est réalisée ici.

Et du côté de l’économie d’espace ?

Comme l’immersion permet d’entreposer des serveurs avec une densité au mètre carré plus importante, cette technologie permet également d’occuper moins d’espace au sol. Et avec cette solution, nous n’avons plus besoin de bâtiments spécifiques pour notre activité. Nous pouvons donc réutiliser du foncier existant ou construire des bâtiments qui pourront avoir d’autres usages. Concrètement, ici, nous avons simplement utilisé une ancienne salle de réunion, et ça en termes de bilan carbone, c’est très intéressant ! Il y a également un avantage du point de vue de la mobilité : ce matériel-là peut voyager, être déplacé. Cela fait donc évoluer la définition même du data center, mais nous permet aussi d’appréhender notre métier ainsi que notre matériel d’une façon totalement différente et novatrice.

Qu’est-ce qui vous a poussé à amorcer la transition de vos data centers vers la technologie à immersion ?

Avec cette technologie, on a pas qu’un wagon, mais presque tout le train d’avance. Elle permet d’avoir à disposition des serveurs puissants, sans travaux lourds, nous ne sommes pas bloqués par la capacité de la climatisation à dissiper la chaleur, ni par les pics de chaleur qui peuvent survenir en été. En effet, le réchauffement climatique est problématique : les data centers d’aujourd’hui n’ont pas été construits pour résister à des pics de température de 40 degrés.

Ensuite, comme il n’y a pas d’oxygène dans cette solution, cela évite à la fois le risque de dépôt de poussières dans les serveurs, l’oxydation de leurs composants ou encore le risque qu’ils prennent feu. On peut alors se passer d’un système incendie onéreux, complexe et générateur de son propre bilan carbone. Concrètement, avec cette méthode, on a juste besoin d’un réseau d’électricité sécurisé, d’un groupe électrogène en cas de coupure et d’un radiateur extérieur qui ne contient que de l’eau, avec seulement un peu d’antigel pour passer l’hiver. Notre objectif à terme, c’est donc de remplacer tous nos data centers classiques par ce type de technologie à immersion. C’est un processus qui devrait durer cinq ans environ.

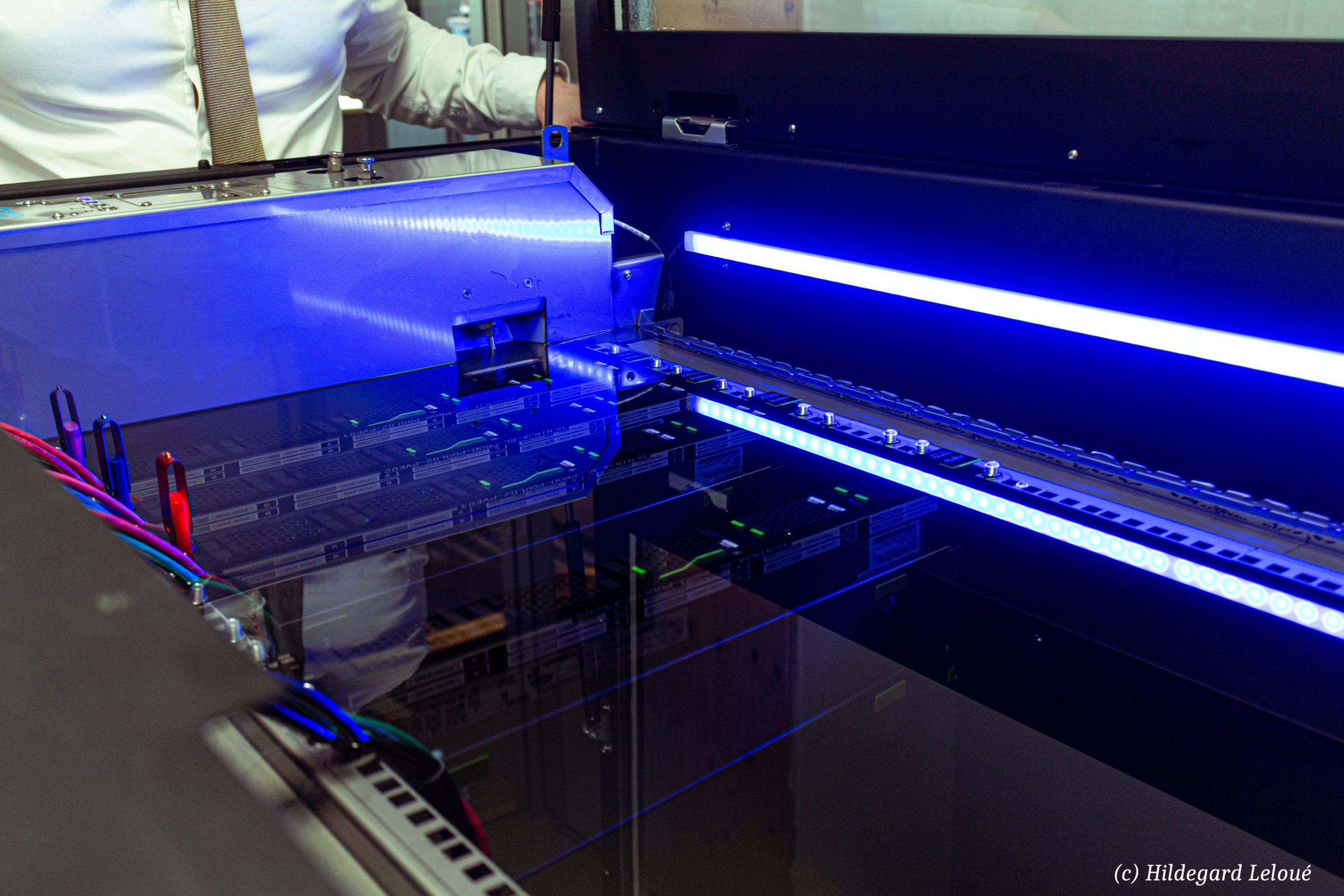

Comment fonctionne cette technologie d’immersion, concrètement ?

Vous avez des serveurs placés à la verticale et intégralement plongés dans une solution d’huile minérale. Tout ce dont on a besoin, c’est d’un échangeur thermique dans lequel deux circuits se croisent : celui du liquide de refroidissement, et un circuit d’eau relié à un radiateur passif situé à l’extérieur, similaire à celui que l’on trouve à l’avant des voitures et dans lequel on fait passer de l’air afin de refroidir une boucle d’eau. Ici, cette boucle d’eau refroidit, à son tour, la solution huileuse dans laquelle sont immergés les serveurs. Une pompe est aussi là pour impulser un peu de mouvement au liquide de refroidissement, et le faire circuler à l’intérieur. Pour intervenir sur les serveurs, on lève d’abord le capot qui assure l’hermétisme, puis on soulève les serveurs à l’aide d’une petite grue. On les égoutte ensuite, avant de les disposer dans un bac spécial nous permettant de travailler dessus.

La composition de cette formule est tenue secrète, mais que pouvez-vous nous dire de ce liquide ?

Ce liquide de refroidissement a de bien meilleures propriétés physiques – caloportrices en l’occurrence – que l’air. Autrement dit, il est capable d’absorber bien plus de calories. Quand on parle de liquide de refroidissement, on imagine facilement un produit assez toxique. Au contraire, cette solution ne l’est pas du tout : elle est transparente comme de l’eau et biodégradable en 48 heures. Pour fonctionner, notre data center n’a besoin de rejeter aucun liquide, mais si ce devait être le cas un jour, ce ne serait pas un problème, puisque le liquide ne contient ni acide ni autre produit corrosif.

Qui a élaboré cette technologie, à l’origine ?

Le principe d’immersion n’est pas nouveau, il était en réalité déjà utilisé dans les années 1980-1990 pour refroidir les ordinateurs – ou plutôt les « supercalculateurs » – de la marque américaine Cray. Ceux-ci plongeaient déjà les circuits de leurs serveurs dans un liquide de refroidissement non-conducteur. La technique est ensuite revenue à la mode il y a deux ou trois ans, notamment grâce à l’essor du Bitcoin. En effet, le « minage », une des activités principales liées à cette cryptomonnaie, est extrêmement énergivore car elle fait beaucoup travailler les ordinateurs, ce qui implique qu’ils chauffent considérablement. La technologie par immersion a donc été remise à jour par une autre société américaine.

Vous êtes le premier hébergeur de données à revendiquer ce système en France, mais auprès de quel marché vous fournissez-vous ?

Le bain à immersion et le liquide qu’il contient viennent de Submer, un partenaire situé à Barcelone, en Espagne. Les serveurs, quant à eux, ont été acquis auprès du japonais Fujitsu, un partenaire de longue date. C’était un travail de longue haleine avec les fabricants de matériel pour qu’ils acceptent de maintenir leurs garanties sur des serveurs que l’on va immerger, puisqu’il s’agit d’une technologie encore peu utilisée et qui ne correspond pas forcément à ce pour quoi ils ont été conçus. Il y avait également quelques modifications minimes à leur apporter au départ : il fallait par exemple ôter leurs ventilateurs et les reprogrammer. Ce travail de discussion et de modification a duré deux ans.

Quels types de structures font appel à vos services d’hébergement ?

A Datacampus, nous sommes hébergeur web, cela signifie que nous permettons, grâce à nos offres et à nos solutions, à tous les publics de louer la juste quote-part de ressources dont ils ont besoin pour leur utilisation spécifique, et avec la garantie que leurs données soient stockées sur le matériel fournissant les meilleures performances énergétiques possibles. Notre objectif, c’est de rendre cette technologie accessible à tout le monde, quel que soit le besoin : que vous possédiez une boîte mail, le plus gros site de e-commerce de France ou simplement un blog pour parler de votre passion le dimanche.

Datacampus défend également le logiciel libre, de quelle manière ?

Nous sommes spécialisés dans les logiciels open source, tout ce qui est Linux, code ouvert… Tous nos locaux fonctionnent ainsi sous Linux, en logiciel libre. A partir de cette base matérielle, nous hébergeons des alternatives aux logiciels des Gafam, que ce soit avec des plateformes de visioconférences ou de travail collaboratif. La différence, c’est qu’on ne fait aucune étude sur les données des clients, nous ne les communiquons pas à des partenaires privés extérieurs pour générer de la publicité ciblée.

Propos recueillis par Hildegard Leloué

Photo : Hildegard Leloué